大模型安全机制是确保人工智能系统安全运行的关键。随着人工智能技术的不断发展,大模型已经成为了人工智能领域的热点。然而,由于大模型的复杂性和规模,其安全性问题也日益凸显。因此,建立一套完善的大模型安全机制至关重要。

首先,我们需要明确大模型安全机制的目标。大模型安全机制的目标是保护人工智能系统的正常运行,防止恶意攻击和数据泄露等安全问题的发生。这包括保护模型免受网络攻击、数据泄露、模型篡改等威胁,以及确保模型的可解释性、公平性和透明度等。

其次,我们需要建立一套完整的安全策略体系。这包括制定安全政策、建立安全管理体系、加强安全培训等。同时,还需要建立一套完整的安全监测和应急响应机制,以便及时发现和处理安全事件。

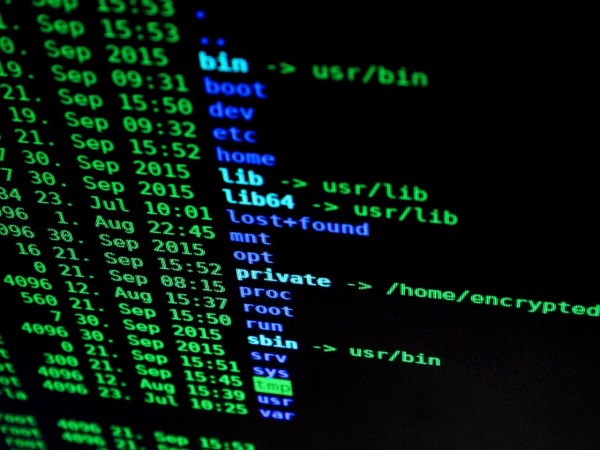

在技术层面,我们需要采用多种安全技术和手段来保障大模型的安全。例如,我们可以使用加密技术对模型进行加密存储和传输,以防止数据泄露;我们可以使用访问控制技术来限制用户对模型的访问权限,以防止恶意攻击;我们还可以使用差分隐私技术来保护模型的隐私性。此外,我们还可以采用联邦学习等技术来提高模型的安全性。

除了技术层面的措施外,我们还需要在管理和运营层面采取相应的措施。例如,我们可以建立严格的数据治理机制,确保数据的质量和完整性;我们可以加强对模型的监控和管理,及时发现和处理安全问题;我们还可以通过定期的安全审计和评估来发现和修复潜在的安全问题。

最后,我们需要建立一套完善的安全文化和价值观。这包括培养安全意识、树立安全责任、倡导安全创新等。只有当所有人都认识到安全的重要性并积极参与到安全工作中来时,我们的大模型才能真正地安全运行。

总之,大模型安全机制是确保人工智能系统安全运行的重要保障。我们需要从多个层面入手,建立一套完整的安全策略体系,采用多种安全技术和手段,加强管理和运营层面的措施,并建立一套完善的安全文化和价值观。只有这样,我们才能确保大模型的安全运行,为人工智能的发展提供坚实的基础。