大模型安全限制是确保技术应用稳健性的关键因素。随着人工智能和机器学习技术的发展,大模型的应用范围越来越广泛,包括自然语言处理、图像识别、推荐系统等。然而,这些模型在带来便利的同时,也带来了潜在的安全风险。因此,我们需要采取一系列措施来确保大模型的安全。

首先,我们需要对大模型进行严格的训练和评估。在训练过程中,我们需要使用大量的数据和标注信息,以确保模型能够准确地理解和处理各种场景。同时,我们还需要对模型的性能进行评估,以确保其在实际应用中能够达到预期的效果。此外,我们还可以使用对抗性攻击等手段来测试模型的安全性,以发现潜在的安全问题并加以解决。

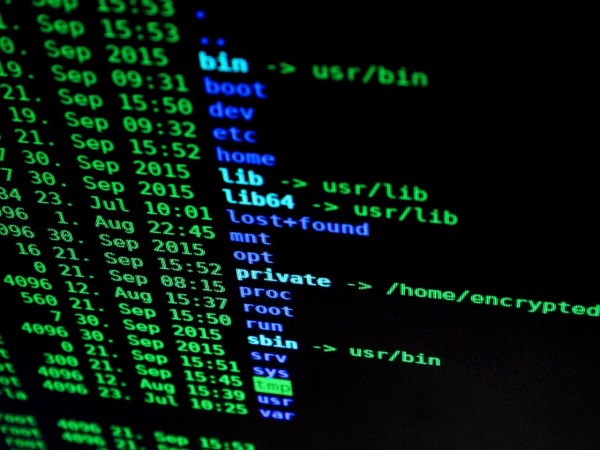

其次,我们需要对大模型进行合理的部署和管理。在部署过程中,我们需要确保模型的运行环境安全可靠,避免受到恶意攻击或病毒感染。同时,我们还需要对模型进行定期的检查和维护,以确保其性能稳定可靠。此外,我们还可以通过设置访问控制和权限管理等措施,防止未经授权的用户访问和使用模型。

第三,我们需要加强对大模型的监控和审计。通过实时监控模型的运行状态和行为,我们可以及时发现异常情况并采取相应的措施。同时,我们还可以通过审计日志等方式记录模型的操作过程和结果,以便在出现问题时能够追溯原因并进行修复。此外,我们还可以利用机器学习等技术对模型的行为进行分析和预测,以提前发现潜在的安全问题并采取措施。

最后,我们需要加强法律法规和伦理规范的建设。在人工智能和机器学习领域,我们需要制定相应的法律法规和伦理规范,明确大模型的使用范围、权限和责任等要求。同时,我们还应该加强对相关从业人员的培训和教育,提高他们的法律意识和道德素质。此外,我们还应该鼓励和支持学术界和产业界开展合作研究,共同推动大模型的安全发展。

总之,大模型安全限制是确保技术应用稳健性的重要环节。我们需要从多个方面入手,采取有效的措施来保障大模型的安全性。只有这样,我们才能充分发挥大模型的优势,为社会的发展做出更大的贡献。