NVIDIA A100 GPU是专门为深度学习和AI应用设计的高性能计算设备,它具备32个张量核心和64个光线追踪核心,能够提供极高的并行计算能力。使用A100 GPU加速AI模型训练可以显著提高训练速度和效率,尤其是在处理大规模数据集和复杂模型时。

一、准备工作

在开始使用A100 GPU加速AI模型训练之前,需要确保以下几点:

1. 硬件准备:确保你的计算机配备有至少一个NVIDIA A100 GPU,以及足够的内存和存储空间。同时,确保操作系统和软件环境(如CUDA Toolkit)与A100兼容。

2. 数据准备:准备要训练的AI模型和对应的输入数据。对于大型数据集,可能需要将其分割成多个小批次进行训练,以充分利用A100 GPU的并行计算能力。

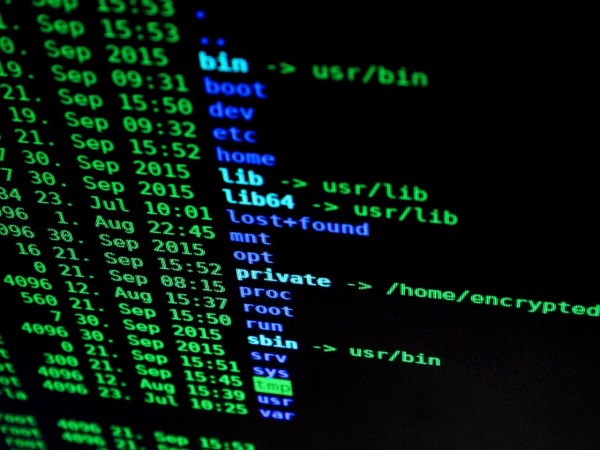

3. 环境搭建:安装CUDA Toolkit和cuDNN库,这些工具是NVIDIA A100 GPU运行深度学习任务所必需的。此外,还需要安装TensorFlow或PyTorch等深度学习框架。

二、训练流程

1. 加载模型:使用TensorFlow或PyTorch等框架将AI模型加载到GPU上。这通常涉及到将模型权重文件复制到GPU内存中,并初始化模型的参数。

2. 设置训练参数:根据问题的性质和数据的特点,选择合适的训练策略,如学习率调度、批大小、优化器类型等。这些参数对模型的训练效果有很大影响。

3. 训练循环:在训练循环中,首先进行前向传播计算,得到当前批次的预测结果。然后,使用反向传播算法更新模型的权重,以减小预测误差。这个过程会重复进行,直到达到预定的训练迭代次数或模型收敛。

4. 监控和调整:在训练过程中,需要定期检查模型的性能指标,如准确率、损失值等。如果性能未达到预期,可能需要调整学习率、批大小、优化器类型等参数,或者尝试不同的模型架构和训练方法。

5. 保存和评估:训练完成后,可以将模型保存为二进制格式的文件,以便后续部署和应用。同时,可以通过测试集评估模型的性能,以确保其在实际应用中的效果。

三、注意事项

1. 资源分配:由于A100 GPU的计算能力强大,因此在训练大型模型时,需要合理分配CPU和GPU之间的工作负载,以避免出现瓶颈。

2. 显存管理:在使用A100 GPU加速AI模型训练时,需要注意显存的使用情况。如果显存不足,可能会导致训练过程被阻塞,甚至导致训练失败。因此,需要在训练过程中定期检查显存使用情况,并在必要时释放不再使用的显存。

3. 并行计算优势:A100 GPU的并行计算特性使得它在处理大规模数据集和复杂模型时具有明显的优势。通过充分利用这一特性,可以在较短的时间内完成训练任务,并提高模型的性能和泛化能力。

总之,使用NVIDIA A100 GPU加速AI模型训练是一个高效而强大的方法,它可以显著提高训练速度和效率。然而,为了实现最佳的训练效果,需要在硬件、软件和训练策略等方面进行细致的规划和优化。